谭娅娅,孔广黔

贵州大学 计算机科学与技术学院,贵阳550025

近年来,随着互联网技术的迅速发展,各种视听设备充斥着人们的日常生活,视频的分享传输也更加频繁。高质量视频的需求也不断增加。在压缩和上传视频的过程中,视频易受到损伤而导致视频质量下降,如丢包、模糊和高斯噪声等损伤行为。因而,对视频质量进行评价是非常必要的。视频质量评价(video quality assessment,VQA)是视频服务系统中的重要技术,在视频编码器性能评测、视频质量监测方面有广泛应用,是为观众提供高质量视频的必要技术[1]。视频质量评价方法有两种,一种是视频主观质量评价方法,一种是视频客观质量评价方法。又根据对原始视频的依赖程度,视频客观质量评价方法可以分为三种类型:全参考(full reference,FR)、部分参考(reduced reference,RR)和无参考(no reference,NR)。全参考需要依靠完整的原始视频;部分参考需要依靠部分原始视频;而无参考不需要依靠原始视频,只需要针对失真视频进行评价。在许多实际情况中,由于难以获得原始视频,因而无参考视频的评价方法具有重要的研究应用价值,成为近年来视频评价方面的研究热点。

在科技快速发展、大数据爆发的当下,VQA方法不再是以传统的基于手工特征的方式进行评估,基于深度学习的VQA 方法成为了大数据下的研究趋势。并且随着多媒体种类的增加,人类接收视觉信息的途径也越来越多,视频的种类也不再单一,出现了立体视频、全方位视频和虚拟现实(virtual reality,VR)视频等多样的视频类型。单一的基于卷积神经网络(convolutional neural network,CNN)的评价方法已不能满足当下情况,对其进行技术扩展使其达到更好的评估效果是非常必要的,开展新型的网络模型是打破瓶颈的必要手段。

本文通过分析近几年来国内外的基于深度学习的VQA方法,概括不同的卷积神经网络模型,了解视频质量评价现状及未来发展趋势,为后续的研究提供参考资料。

1 视频质量评价

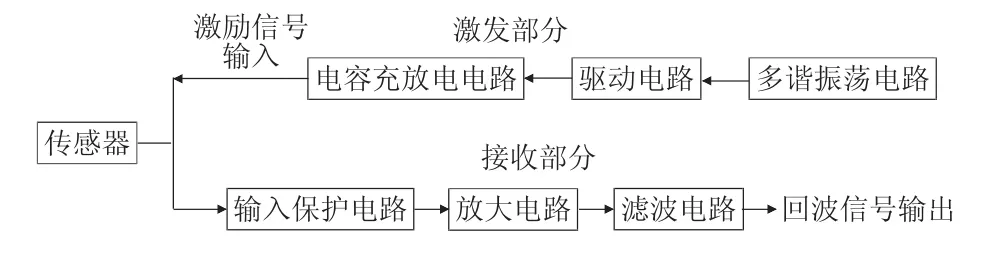

视频质量评价是指通过特定的评价方法对两段主体内容相同的视频信息的变化和失真进行感知、衡量和评价,在指导视频编码压缩和视频质量监控领域有重大应用[2]。评价方法分为视频主观质量评价方法和视频客观质量评价方法两种。视频主观质量评价方法是让观测者对视频质量做出直观判断,主观评分一般是由平均主观得分(mean opinion score,MOS)或平均主观得分差(difference of mean opinion score,DMOS)表示。主观质量评价方法虽然是最为准确的评估方法,但是其结果容易受到多种因素影响且方法复杂。因此,大多采用易于实现的视频客观质量评价方法。客观质量评价方法是计算机通过某些算法从人类的主观评分角度出发,从而预测给定视频的评分,又根据对原始视频的依赖程度,可将其分为三种类型:全参考、部分参考和无参考。根据是否引入深度学习方法,又可将其分为非深度学习的客观评价方法和深度学习的客观评价方法。如图1所示,从主客观两方面对视频质量评价方法进行分类,并列举出典型的评估方法。

![图片[1]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173734-686ffa5e91291.webp)

Fig.1 Classification of video quality assessment图1 视频质量评价分类

1.1 主观质量评价

主观质量评价方法是通过观察者的评分归一化来判断视频质量。在ITURBT.500 建议书中,有主观评价的相关标准。常用的评价方法有双刺激损伤分级法(double stimulus impairment scale,DSIS)、双刺激连续质量评价法(double stimulus continuous quality scale,DSCQS)、单刺激方法(single stimulus methods,SSM)、单刺激连续质量评价法(single stimulus continuous quality evaluation,SSCQE)等。其中DSIS 评价方法采用的是让观察者待在一个受控的环境中,连续观看一定时间内的多个测试序列对,其中包括原始参考视频和失真视频。在每次观看时,先看原始参考视频,再观看失真视频;然后采用五级评分方法(质量尺度为优、好、中、差、劣五类)让观察者对视频序列的质量进行评分;最后求得MOS 来判断视频质量并对所得数据进行分析。

虽然主观质量评价是最为准确的评估方法,但需要考虑多种因素,如观测环境、观测时长、观测距离以及观看参考视频和失真视频的先后顺序等因素,并且人类视觉系统易受到时间掩蔽效应[3]的影响,即当存在大运动时,相对于运动物体不太明显的色调、亮度等微小变化,人类是无法察觉的。而且在主观质量评价中需要大量的观测人员以及专业化的实验环境,需要花费大量的时间和费用,成本较大,且不利于实施。因此,在实际情况中需要一种客观的、易于实现的视频客观质量评价方法。

1.2 客观质量评价

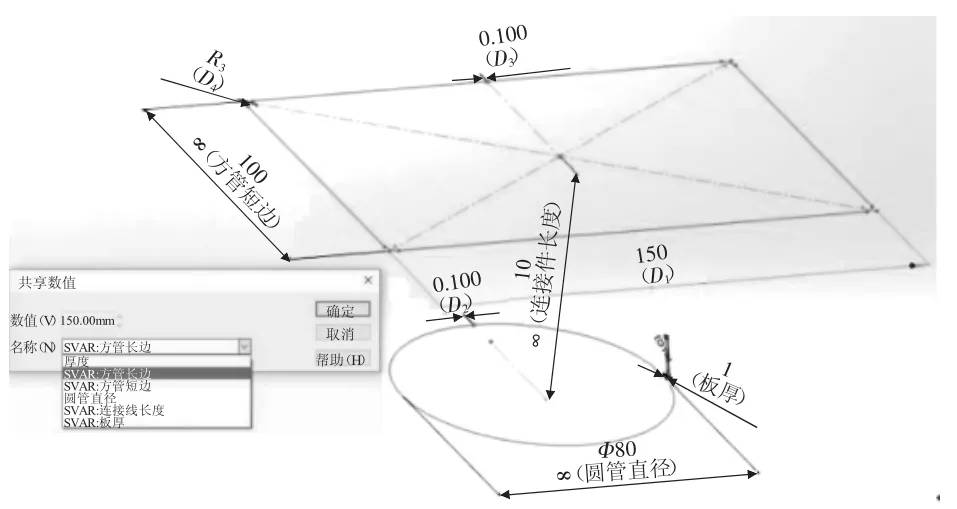

客观质量评价方法是计算机根据算法计算出视频质量的量度。要求在相同的测试序列下,客观评价的结果要与主观评价的结果相一致,可以从预测的单调性、一致性、稳定性和准确性来衡量评价量度本身的优劣。根据对原始参考视频的依赖程度,客观质量评价法又可以分为三种类型:全参考、部分参考和无参考。如表1所示,从原理、不同点和代表性方法方面对三种类型进行了对比。其代表性方法有基于运动的视频保真度评价方法(motion-based video integrity evaluation,MOVIE)[4]、ST-MAD(spatiotemporal most-apparent-distortion)[5]、结构相似度算法(structural similarity,SSIM)[6]和V-CORNIA(video codebookrepresentation for no-reference image assessment)[7]。

在传统的质量评估方法中,常常采用低复杂度且简单的均方误差(mean square error,MSE)和峰值信噪比[8](peak signal to noise ratio,PSNR)等评价方法,但由于它们未能充分地考虑人眼的视觉特性,因而会导致客观评价与实际视觉效果不一致的结果。随后提出了基于人眼视觉特性(human visual system,HVS)仿生的算法以及支持向量机(support vector machine,SVM)方法[9]等,与MSE和PSNR相比,有了很大的改进,但依旧未能达到期望值。Seshadrinathan等人提出了MOVIE[4]方法,考虑视频中的运动信息,获得了较好的性能评价,但在多数情况下难以获得足够的参考信息。Mittal 等人提出一种基于空间域自然视频统计(natural video statistic,NVS)的模型[10],用于建模时空关系的感知相关特征;Saad等人[11]结合时空NVS和运动相关性提出了一个无参考的质量评价方法,以此进行质量评估。随后,以HVS 和NVS为基础扩展的评估方法[12-13],虽有较好的准确率和响应速度,但这些方法都需要大量的手工提取特征,且特征提取复杂、耗时,难以做到无监督学习。

总之,由于传统方法的种种局限性,要使客观质量评价方法与主观质量评价方法结果达到一致是较为困难的。而随着深度学习的发展,计算机视觉领域达到了新的高度,对于图像和视频的处理有很大的突破。由此,基于深度学习的更精确、更高效的VQA方法受到了更广泛的关注。

2 基于深度学习的客观质量评价

深度学习网络可以提取到高层次、高区分性的特征,更好地使主观评价结果与客观评价结果达到一致。在基于深度学习的质量评估方法中,大多采用的是基于卷积神经网络的模型,例如Callet等人[14]首次提出将CNN应用到客观的VQA上,虽然只解决了对SSCQE 方法的预测问题,但这是传统方法向深度学习方法过渡的开端。Kang 等人[15]提出了一种NR 图像质量评价(image quality assessment,IQA)方法,这是CNN 首次用于通用NR-IQA,是可视质量评价方向的一大进步。

然而,在VQA方面,2D-CNN主要是将视频的一帧作为输入,易忽略各帧之间的关联信息,难以捕获时间信息。而三维卷积神经网络(three-dimensional convolutional neural network,3D-CNN)以连续的多帧作为输入,增加时间维度信息,能够提取到更具表达性的特征。因此,3D-CNN 将更适合视频分析处理。目前在视频质量评估方面,通常考虑全参考型和无参考型的两种类型的评价方法;大多采用基于2DCNN 的方法和基于3D-CNN 的方法,其中2D-CNN要引入迁移学习及其他的时空特征提取技术来弥补其不足。

![图片[2]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173736-686ffa6079f5f.webp)

Table 1 Comparison of objective quality assessment methods表1 客观质量评价方法对比

2.1 全参考型评价方法

在深度学习中,模型训练测试的前提条件就是必须具备极大的数据量。而全参考视频评估方法必须提供完整的原始参考视频与失真视频进行对比评估,但这往往是难以获得的。一方面是因为,现有的包含原始参考视频、具有规范性且数据规模大的公开视频数据集较少;另一方面,自制视频数据集需要高成本的代价,人力、物力都是难以达到的。因此,全参考的评价方法虽然比无参考的评价方法更具有准确性,但依旧存在由样本数据不足引起的评估效果不佳等问题。为解决此类问题,大多模型采用迁移学习,通过特征迁移,以图像特征丰富视频特征,或以迁移模型提高评估能力。

图2 是基于深度学习的FR-VQA 方法的一般框架图。FR-VQA 方法流程大致分为四个步骤:预处理、特征提取、特征融合和回归模型。预处理部分对输入的视频数据进行大小的归一化,包括视频数据的长、宽和时间长度。设置输入形式,以一帧帧图像作为输入或是以连续几秒的视频块作为输入;特征提取部分以CNN 网络为基础进行卷积提取特征,在FR-VQA 方法中需各自提取原始参考视频和失真视频的时空特征;大多采用级联的方式将参考视频特征和失真视频特征融合;最后以融合后的时空特征以及对应原始参考视频的MOS 作为回归模型的输入,回归模型大多采用全连接层学习整体的感知质量和目标质量分数的非线性回归关系;最后得到失真视频的质量分数。以下对近年来的一些典型FRVQA方法进行介绍。

![图片[3]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173737-686ffa61c32f9.webp)

Fig.2 FR-VQA method frame图2 FR-VQA方法框架

由于样本数据的不足对训练效果有很大的影响,而现今可用的包含原始参考视频和失真视频的VQA 数据库中的样本非常有限且分布不平衡,缺乏内容丰富、失真程度多样和标签平衡的失真视频。对于样本不足的情况,常考虑使用迁移学习或预处理等方式解决。如Zhang 等人[16]模仿基于特征的迁移学习框架,将失真的图像和视频转移到一个共同潜在的特征空间中进行预处理,以特征迁移来丰富失真样本,有效解决了训练样本和标签不足的情况。在池化后引入后处理技术,可以有效抵消组间标签错误造成的偏差。与其他网络相比,预处理和后处理的引入,有效地减少了FR-VQA 指标预测的不准确标签的影响。然而,由于采用经过交流分量系数(deformations of alternating current(AC component)coefficients,DAC)变形的视频块作为输入,使得模型更具复杂性,但性能相比当时其他模型较好。

另一方面,VQA的目的是准确地衡量视频内容的人眼感知质量。然而,现有的将视觉感知纳入VQA的模型大多具有局限性,无法准确、高效地将人眼视觉感知纳入到模型中。考虑到这一问题,Kim等人提出了DeepVQA[17]。通过CNN 和卷积神经聚合网络(convolutional neural aggregation network,CNAN)来量化时空视觉感知。借鉴了“注意力机制”的思想[18-19],提出CNAN 来对每一帧的预测质量分数进行加权,在时间池化方法中考虑了预测分数的整体分布,而非单一帧的质量分数,以此提高模型的评估效果。与未使用CNAN 的模型对比,使用了CNAN 的模型提高了整体预测的性能。然而,2D 卷积难以很好地保留时域信息。为了能够更好地捕获视频时间特征,提出了以3D卷积来处理视频信息。如Xu等人提出了C3DVQA(convolutional neural network with 3D kernels(C3D)for video quality assessment)方法[20]。使用3D卷积学习时空特征,捕获视频的时间掩蔽效应,模拟HVS 的质量评估过程。3D 卷积的引入提高了模型的性能,但需在更大规模的数据库中进行推广,进行更全面的实验,验证模型性能。Li 等人认为物体的运动将影响人类的视觉体验[21],创新性地提出评估复杂运动场景中人体运动质量的3D-CNN 网络模型。使用特征映射图提取参考视频和失真视频的局部相似度,最后结合权重以获得整体图像质量分数。作为全参考模型,其评估效果一般,其原因可能是只考虑了物体运行时的质量效果,物体运动过程中带有了许多不确定性,难以全面处理。其模型性能还需通过数据预处理来提高,可参考文献[20]中的以参考帧与失真帧之间的残差帧为输入,通过增加不同类型的输入来获得更多的特征。

FR-VQA 方法虽能使用2D-CNN 和3D-CNN 网络达到良好的评估效果,但由于现有的原始参考视频数据库少,并且难以获得,2D-CNN 模型虽能采用迁移学习的方法解决样本不足问题,但引入的预训练模型也导致模型训练中参数过多,且未能充分利用到时域信息;使用了3D 卷积的FR-VQA 方法虽能达到很好的评估效果,但泛化能力有待评估,且在实际应用中没有原始参考视频进行对比,致使全参考型模型并不适用。由于这些局限性,导致全参考型方法并不实用,因而无需参考原始视频的无参考型评价方法得到了更多关注,具有更大的研究应用价值。

2.2 无参考型评价方法

NR-VQA 方法又称为盲视频质量评价(blind video quality assessment,BVQA),无需提供原始参考视频,只需根据失真视频的自身特征估计视频质量。与FR-VQA 相比,NR-VQA 提供了更大的可能性,且现今的评估方法大多针对通用的失真类型。因而NR-VQA 方法最具实用价值,有着非常广泛的应用范围。图3 是基于深度学习的NR-VQA 方法的一般框架结构图。NR-VQA 方法与FR-VQA 方法流程相似,只是去掉了参考视频的特征提取和特征融合部分。

![图片[4]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173739-686ffa6344bad.webp)

Fig.3 NR-VQA method frame图3 NR-VQA方法框架

现有的NR-VQA方法还面临着一些问题:(1)在一些数据库中,训练样本不均衡,数量不足;对于一些特殊的视频类型,如VR 视频类型,难以得到其数据库,需要自己手动创建。(2)视频的失真类型多样,而标准NR-VQA 是专为特定类型的失真而设计的,具有局限性,缺乏通用性。(3)对于自然失真视频数据库,难以达到较好的评估结果。下文将NR-VQA模型分为基于2D-CNN 的方法和基于3D-CNN 的方法两部分进行介绍。

2.2.1 基于2D-CNN的方法

在2D-CNN 中,卷积只能表示二维的特征图,每进行一次二维解算操作,时域信息就会丢失。一般的CNN 并不适合处理具有三维时空规律的视频,即使以视频块作为输入,也很难得到适中的评估效果,并且样本的缺乏使得网络难以训练。因此,在基于深度学习的VQA中,大多采用经过预训练的CNN模型结构和其他技术组合的方法进行质量评估。

在视频质量评价中,设计一个对于任何失真类型都适用,且能保证与人类主观视觉感知一致的算法模型是非常必须的。如Li 等人提出了SACONVA(shearlet-and CNN-based NR-VQA)[22]方法,启发灵感来源于NR-IQA[23]。考虑到将视频视为静态图像,以一帧帧图像作为输入并不能有效提取时间运动信息的问题,此算法以视频块为输入,通过三维剪切波变换提取时空特征,三维剪切波变换可以有效处理时域信息,其稀疏性质可改进算法的评估能力。然后经过平均池化得到相应的特征向量,再利用CNN 网络和逻辑回归用于预测视频质量。此算法为VQA方法提供了一个利用通用CNN 的范例,并证明了在盲视频降噪等实际情况中的应用。然而,该算法虽然与人类的视觉感知有着良好的相关性,但依然存在训练失真视频的数量有限和标签不均衡等问题,限制了算法的性能、鲁棒性和泛化能力。由此,Wang等人[24]提出将视频中的时空特征分开提取,一是利用CNN 学习帧级的空间质量特征,二是利用自然场景统计特性(natural scene statistics,NSS)[11]捕获时间运动特征;最后考虑到人的心理感知,训练一个多元回归模型来决定最终的视频质量。在当时条件下,该方法优于其他NR-VQA方法。但在时间特征的提取方面引入了手工特征提取,且将时空特征分为空间特征和时间特征进行提取再融合,这并不利于时空特征的充分提取。Ahn等人提出DeepBVQA方法[25]。引入迁移学习,由经过预训练的CNN 提取每个视频中的空间线索,采用手工提取方法提取时间线索特征。算法性能只是相关性值略高于其他VQA 模型。整体上,算法的性能并不好,且引入了手工特征提取。文献[24]和文献[25]都是半深度学习方法,都需要摆脱手工提取时间特征。文献[26]中也引入了迁移学习,从经过预训练的CNN中获得特征,但未使用手工提取方法提取特征,而是结合了时间池化方法进行特征信息融合,最后以支持向量回归(support vector regressor,SVR)映射到质量得分上。迁移学习的引用弥补了样本的不足,改善了模型训练效果。

另一方面,有效提取自然视频中的时空特征有利于训练算法的性能,得到更好的结果。考虑到一些NR-VQA 算法难以有效、全面地提取自然视频的三维时空特征。Zhang等人[27]以FR-VQA度量得出视频块的弱标签和相应的主要特征作为输入,以此丰富训练集;引入模型迁移,利用预训练的CNN 模型,且为提高从失真视频到质量分数的映射函数性能,应用重采样策略生成将深层特征映射到质量得分的回归函数。算法采用多种方法来丰富样本和提高评估性能,取得了较高的精确度。但依旧存在问题:训练样本不均衡,数量不足,迁移样本由人工选择以及FR-VQA指标产生的弱标签引入了噪声。Utke等人[28]以具有主观质量评估能力的视频多方法评估融合[29-30](video multimethod assessment fusion,VMAF)模型为参考,通过组合多个基本质量指标来预测主观质量。VMAF 模型采用三个基本指标:衡量空间特征的视觉信息保真度[31]、细节丢失指标[32]以及具有时间特性的运动量。以SVM将这三个基本指标融合为一个最终指标,并为每个基本指标分配一定的权重,保留指标的评价优势,从而获得更精确的评估分数,分数范围在[0,100],分数越高质量越好,其评估结果与最终人眼感知达到完全线性正相关关系。然后再利用经过预训练的DenseNet[33]网络对游戏视频流中的质量进行评估。然而,此方法的计算量大,不利于实施,胜在创新性地对游戏视频流进行评估,有巨大的前景需求。

考虑到VQA 模型的一个主要目的就是要在自然失真视频数据库上达到优良的效果。但大多模型都只能在人为制造的失真视频上达到良好效果,在自然失真视频数据库上难以达到好的结果。由此,Varga 等人提出了一种基于长短时记忆网络(long short-term memory,LSTM)和CNN 的通用算法[34]。这是第一个基于自然视频质量数据库的深层架构。比较创新的是,它将视频序列作为CNN 提取的深度特征的时间序列,利用经过预训练后的CNN 模型提取帧级深度特征,以此作为LSTM 网络的输入,训练两层的LSTM 网络和一层全连接层来预测质量分数。利用LSTM 网络学习感知质量预测的长期依赖关系,可以有效地发现在NR-VQA 中可能有用的长期时间关系。算法在具有真实自然失真序列的KoNViD-1k[35]视频数据库上进行训练,其性能略优于当时最先进的方法。与文献[34]相似,Li等人[36]使用具有门控制的递归神经网络(gated recurrent neural network,GRU)对时间记忆进行建模,以学习感知质量的长期依赖关系,并在自然失真数据库中验证了方法的有效性。

以上2D-CNN结构的网络模型,大多引入迁移学习,采用经过预训练后的CNN模型ResNet-50、VGG-16、Inception-V3 和AlexNet 等网络,以此来提高模型的评估能力。特征迁移和模型迁移的引入虽能弥补训练样本过少的问题,提高算法性能和速度,但网络中的卷积操作并不能很好地反映帧与帧之间的时序关系。对于难以捕获时间信息的问题,一些方法或多或少地引入人工提取特征,这并不高效;或通过三维剪切波变换等技术来高效提取时空特征,以提取到的多方位、多角度的时空特征映射到最终的质量得分回归函数,通过增加特征的方式来提升模型的评估能力。而对于文献[34,36]提出的方法,以循环神经网络来解决时序问题,通过充分利用时间信息提取特征来提高模型性能。且在自然失真视频数据库上得到验证,并取得较好的效果。为应对自然失真的实际情况,模型的泛化能力还需提高。未来可能更加关注递归循环神经网络模型的研究。综上,在基于CNN的方法中加入其他技术进行辅助能很好地应用在质量评估上,有效改善2D卷积上时域信息丢失问题,但数据预处理方面并不简单,依旧存在未能充分利用时间信息的问题。

2.2.2 基于3D-CNN的方法

在2D-CNN中,卷积仅从空间维度计算特征。而在视频处理问题上,为了能够捕获到多个连续帧中的运动信息,提出用3D卷积来计算空间和时间维度特征。与2D卷积不同,3D卷积中的输入图像多了一个时间维度,这个维度可以是视频上的连续帧,也可以是立体图像中的不同切片。3D卷积通过堆叠多个连续帧,从而组成一个立方体,然后在立方体中运用3D 卷积核[37]。在整个卷积过程中,都是使用同一种卷积核,也就是权值共享。在输出上,2D卷积的结果是一张包含高和宽的特征图,而3D卷积的结果是一个包含高、宽和时间维度的立方体。如图4 所示[37],对比了2D卷积和3D卷积操作,其中H、W表示输入图像的高度和宽度,K×K表示卷积核的大小,L可以视为L帧的视频,d为卷积核的深度。

由于3D 卷积可以有效保留时间信息,将更适于视频分析。例如Liu 等人提出了视频多任务端到端优化的深度神经网络(video multi-task end-to-end optimized neural network,V-MEON)[38]方法。启发来源于对于图像的质量评价方法MEON(multi-task endto-end optimized neural network)[39],将特征提取部分和回归部分共同优化,可预测最终的质量分数。特征提取部分中将2D卷积改为3D卷积,有利于时空特征的提取,并且利用慢融合结构的滤波器捕获了更多的时空信息。评价结果表明,此方法比当时最先进的通用BVQA 模型性能更好,具有评估增强视频感知质量的潜力,有助于改进视频增强算法。再如Hou等人提出一种三维深度卷积神经网络[40]。网络模型由经过预训练的VGG网络前12层和一个3D-CNN架构组成,前者使用卷积操作提取视频内部每一帧的质量敏感特征,后者以3D卷积充分提取时空特征,最后利用全连接层进行回归操作对视频质量进行评估。采用基于bin 的平均池化,有效防止过拟合,且方便提取特征的卷积结构并加快收敛速度。算法性能结果优于当时的其他NR-VQA 方法,甚至优于某些流行的FR-IQA方法。

另一方面,现有的视频类型多种多样,立体视频、全方位视频和VR 视频等多角度、全方位的视频已经大规模地出现在人们的生活中,因此,对于不同视频类型的质量评价研究也是非常必要的。不同于平常的二维视频,这些类型的视频更加复杂、多样,一般的VQA 方法难以进行。但是,使用3D-CNN 模型也能进行准确的评估,例如Yang 等人提出基于3D-CNN 的立体视频质量评估(stereoscopic video quality assessment,SVQA)框架[41],是首个将3D-CNN应用到评估立体视频质量的方法。使用三次差分视频块作为输入,能够有效地建模局部的时空信息和全局的时间信息。设计3D-CNN 架构来自动有效地捕捉局部空间特征,比通过手工提取的特征更准确、更方便;且不需要复杂的预处理和GPU加速,计算效率高,易于使用。再如Yang等人提出针对VR视频的基于3D-CNN的端到端网络框架[42],由于数据库的缺少,建立了一种VR 质量评价的免费可用数据集(VRQ-TJU);将VR视频的局部时空特征与质量分数融合策略相结合,从而得到视频的客观预测分数。此方法是首个利用3D-CNN 来评估VR 视频质量的方法,无需复杂的预处理。算法的结果与主观质量评价结果一致。由于只是在自建的数据库上训练,因此实验缺乏丰富性。Wu 等人也提出一种基于自建数据库的虚拟现实质量评价方法[43]。使用3D-CNN来预测虚拟现实视频的质量,采用不同的质量分数策略得到最终的分数。结果表明,该方法比传统方法具有更好的性能,并且结合权重后的网络性能更好。

文献[42]中视频质量评价的3D-CNN 结构图如图5所示,其框架由两个3D卷积层C1、C2,两个3D池层S1、S2 和两个全连接层FC1、FC2 组成。以10个图像补丁组成的32×32大小的视频补丁为输入,无需人工提取特征;第一层是3D 卷积层,对输入采用3×3×2的卷积核进行卷积,输出50个大小为30×30×9的三维特征图;第二层采用大小为3×3×3卷积核进行最大池化,得到50 个10×10×3 的三维特征图;第三、四层依次进行卷积、池化;第五、六层采用全连接层;最后,采用质量分数融合策略解决VR视频中的空间分布不均匀问题,输出为512维特征向量以及最终的客观质量分数。作为首个应用于VR 视频质量评价的3D-CNN 模型,由于缺少VR 视频数据库,因而在自建的VRQ-TJU 数据库上进行训练。对于全方位、多角度的VR视频,模型的输入只是进行了简单视频大小划分的预处理,未进行复杂的特征变化处理。且模型结构简易,最终取得了与主观质量评价一致的结果。但数据库的缺乏,难以评估模型的泛化能力。

![图片[5]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173740-686ffa64c1154.webp)

Fig.4 Comparison between 2D convolution and 3D convolution operation图4 2D卷积与3D卷积操作对比

![图片[6]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173742-686ffa665b97d.webp)

Fig.5 3D-CNN structure diagram图5 3D-CNN结构图

与2D-CNN相比,3D-CNN在处理视频方面有更大的优势。3D卷积的网络模型充分保留了输入的时间信息,在训练中提取到了更全面、更可靠的时空特征,由此提升了模型的评估能力。且训练过程中无需复杂的预处理和高速运算,有更高的计算效率且易实现。因此,3D 卷积更适于视频分析。并且对于复杂的、多样化的VR视频等,3D-CNN模型也能很好地进行训练评估,但由于缺少内容丰富的视频数据库,其泛化能力需加强研究,且在自然失真视频数据库上的评估效果不佳,其研究还待加强。未来,对于适合视频处理的3D-CNN模型或将得到更多的关注。

3 算法性能比较3.1 视频质量评价数据库

在视频质量评价研究中,建立失真类型多样、内容丰富且包含MOS评分的视频数据库是视频质量评价研究中不可缺少的一部分。而现有的视频数据库多种多样,常用的视频数据库有LIVE[44]、CSIQ[45]、IVP[46]和KoNViD-1k[35]等。对于其他类型的视频,也有相应的数据库。在全方位视频数据库方面,有头部运动(HM)数据库[47-48],也有包括HM数据和眼部运动(EM)数据的数据库[49]。在立体视频方面,有CornellA57[50]、VQEG[51]、NAMA3DS1[52]等立体视频数据库,包括了原始立体视频和失真立体视频以及MOS评分。在此仅介绍部分视频数据库。

(1)LIVE数据库[44]:10个参考原始视频和150个失真视频。4 种失真类型:Wireless 压缩失真、IP 失真、H.264 压缩失真和MPEG-2 压缩失真。每段视频对应一个DMOS得分,分值范围为[0,100],分数越高,视频质量越差。

(2)CSIQ数据库[45]:12个参考原始视频和216个失真视频。6种失真类型:H.264/AVC压缩失真、具有丢包率的H.264 视频、MJPEG 压缩失真、小波压缩失真、白噪声和HEVC 压缩失真。每段视频对应一个DMOS得分,分值范围为[0,100],分数越高,视频质量越差。

(3)MCLV数据库[53]:12个参考原始视频和96个失真视频。两种类型的压缩失真:具有4个不同质量等级的原始视频的H.264/AVC 压缩失真和具有4 个质量等级的缩小原始视频的H.264/AVC 压缩失真。所有失真的视频都提供MOS 得分的平均值和MOS得分的偏差。

(4)VQA-ODV数据库[54]:由600个全向序列的主观评分、HM 数据和EM 数据组成的大规模全向视频VQA 数据库。600 个序列中包括60 个参考序列和540 个受损序列,它们在内容、持续时间和分辨率上都存在差异,压缩和地图投影都存在缺陷。

(5)VRQ-TJU 数据库[42]:13 个参考VR、104 个对称失真VR 和260 个非对称失真VR 和相关MOS 组成。是针对VR视频质量评价构建的VR数据库。

3.2 评价性能指标

客观视频质量评价方法的性能指标使用最广泛的是Pearson 线性相关系数(Pearson linear correlation coefficient,PLCC)、Spearman秩序相关系数(Spearman rank-order correlation coefficient,SROCC)、Kendall秩序相关系数(Kendall rank-order correlation coefficient,KROCC)和均方根误差(root mean square error,RMSE),它们常常用于测量两个变量之间的相关程度。

Pearson线性相关系数用于预测值与主观评分之间的相关性,其计算值的范围在0 到1 之间,相关性值越大,性能越好。计算公式如下:

![图片[7]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173743-686ffa67ad002.webp)

其中,N表示失真视频的数量,Ai表示第i个视频的主观评价分数,Bi表示通过客观评价模型得到的第i个视频的质量预测分数,Aˉ和Bˉ分别表示主观预测值和客观预测值的均值。

均方根误差用于衡量算法的准确性,准确性值越小,表明误差越小,模型性能越好。计算公式如下:

![图片[8]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173745-686ffa69051b4.webp)

Spearman 秩序相关系数和Kendall 秩序相关系数用于衡量算法的单调性,单调性值越大,性能越好。计算公式如下:

![图片[9]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173746-686ffa6a4bac7.webp)

其中,Di表示第i个失真视频的主观评价值与客观预测值之间的差异,Nc代表数据序列中序号对一致的个数,Nd代表数据序列中序号不一致的个数。

3.3 算法对比

统计各算法在不同数据库上的Pearson线性相关系数(PLCC)和Spearman 秩序相关系数(SROCC)的值,PLCC 和SROCC 分别衡量算法的相关性和单调性。整体过程:对比数据由各自算法提供,数据不全且未开源的算法模型不参与对比。未命名的算法以其开头作者名代替,每项数值保留小数点后三位,性能最好的算法数值用加粗标出。算法针对的失真类型都是混合型失真,即算法对数据库中所有类型的失真进行随机训练,而非对某一类失真类型进行单独训练。算法中若进行了多种情况的比较,选择效果最好的一次加入对比,所选数据库有LIVE、CSIQ和KoNViD-1k。

如表2 所示,比较了全参考型算法和无参考型算法在三个视频数据库上训练的效果。为更直观地进行比较,在全参考型算法中加入典型的PSNR、MOVIE[4]和STMAD[5]算法进行对比。特别地,引入了最新的STS(space-time slices)类算法[55],此算法以参考视频和失真视频的各类特征图为输入,如边缘增强图、帧差异图和相对梯度量图等,使用典型的IQA 模型(PSNR、SSIM[56]和视觉信息保真度算法(visual information fidelity,VIF)[57])对视频质量进行训练,由此有三种算法STS-PSNR、STS-SSIM和STSVIF。在无参考型算法加入典型的V-BLIINDS(video blind image integrity notator using discrete cosine transform statistics)[11]和V-CORNIA[7]算法进行对比。

如表2 所示,与传统的典型算法相比,加入3D卷积的全参考型C3DVQA 算法在整体上有最好的评估效果,在LIVE 和CSIQ 数据库上的PLCC 值和SROCC 值都达到0.900 以上的评估值,这是非常可观的。与STS 类算法相比,C3DVQA 在LIVE 数据库上的PLCC 值低于STS 类算法,最差比STS-PSNR低了0.036,其他数值远高于STS 类算法。其次是DeepVQA 算法,整体效果较为均匀,只是LIVE 数据库的PLCC 值为0.895,低于STS 类算法和C3DVQA算法,其相关性还需加强。值得关注的是,STS 类算法用的是典型的IQA 模型进行视频分析,其评估效果远高于典型的VQA 算法。而加入3D 卷积的MEON 和3D-CNN VQA 等无参考算法效果一般,最好的评价结果也未超过0.850,其原因可能是视频失真的复杂性使得模型在学习的过程中未能提取到多样的时空信息。而2D卷积的各个无参考型算法大都表现均匀,但评估效果都未有达到0.900 以上的,远低于全参考型模型。可以推断,即使无参考型模型更符合当下的情况,但全参考型模型评价效果依旧是最好的,所依赖的原始参考视频为算法提供了好的依据,有效提高了算法的评估能力。无参考型模型还需更进一步研究,以改进模型的性能。其次,对比算法在自然失真视频数据库KoNViD-1k上的评价效果,文献[26]和文献[34]是由同一研究团队先后发表的。文献[34]所提算法在KoNViD-1k 数据库上的整体效果较为均匀,PLCC 值和SROCC 值分别为0.867和0.849,但在人为制作的失真视频数据库LIVE上却表现不佳,其PLCC 值和SROCC 值只有0.691 和0.703,远低于0.800。而在文献[26]所提算法中也有类似情况。可能是由于KoNViD-1k数据库中不具有LIVE 数据库中的失真视频类型导致的。而Li 中的相关性表现较差,PLCC 值只有0.744,其原因可能是在全局池化过程中保存的信息不足。与典型的VBLIINDS 和V-CORNIA 算法相比,这些算法都有很大的提升,尤其是在自然失真视频库KoNViD-1k上。

![图片[10]-基于深度学习的视频质量评价研究综述-游戏花园](https://www.hunggame.com/wp-content/uploads/2025/07/20250710173747-686ffa6bae800.webp)

Table 2 Algorithm performance comparison on database表2 算法在数据库上的性能对比

从整体上看,相比无参考型算法,全参考型算法表现出更好的评估效果,最高可达到0.900以上的评估效果值,但由于训练测试的数据库较少,难以看出其泛化能力。可通过增加不同的数据库训练算法,以交叉检验的形式说明算法的鲁棒性。对于STS 类算法,未使用复杂的网络模型,创新地利用典型的IQA网络进行视频处理。虽在预处理过程中,使用了复杂的STS[58]技术提取时空特征图,但评估效果非常可观。因而,在追求前沿、复杂算法模型的同时,也应保持对经典算法的探究,其价值不可小觑。在实际情况中,面临的是没有原始参考视频的自然失真情况,因此,无参考型依旧是最具研究价值的,但采用2D 卷积或3D 卷积的无参考模型的评估效果都难以达到全参考型的高精度。考虑到此问题,一方面,是否可以通过多角度、多方位提取失真视频的特征图来丰富输入数据,以此提高算法性能;另一方面,在IQA 方法也存在此类问题,它引入对抗神经网络于NR-IQA[59-62]中,以重建伪原始图像来将无参考问题转为全参考问题,以此提高算法性能,是否VQA方法也可以从此处找到突破点。对于视频自然失真的情况,算法较为稀少。虽可以通过设计循环神经网络模型得到较高的评估效果,但泛化能力较差。无参考型模型要在实际应用情况上达到高效的评估能力还需进一步探究。

4 总结和展望

本文对基于深度学习的视频质量评价方法进行了综述,根据在客观质量评价方法中有无参考原始视频进行划分介绍。对基于深度学习的BVQA方法从2D-CNN 和3D-CNN 两类框架上进行对比。目前在图像方面的研究已日趋成熟,大多通用的NR-IQA方法[63-69]已经得到实际应用,新型的IQA 方法[70-71]也取得了很高的评估效果,对于全景图像、VR 图像等特殊图像方面的IQA 方法[72-73]也得到极大的技术提高。在视频方面,主观的VQA方法已经基本成熟,但成本较大,并不适用;在客观的VQA 中,与FR-VQA方法相比,无需原始参考视频,更符合VQA实际情况且易推广到实际应用中的NR-VQA方法获得了更多的关注;而基于深度学习的方法比传统方法更高效、更精确,成为VQA 研究人员的主要研究方向。又由于3D-CNN比2D-CNN更适用于视频分析,对于复杂的立体视频[74-75]、全方位视频[76-79]以及VR视频[80]的研究也可使用3D-CNN 进行,且消耗资源少。因此,使用3D 卷积的NR-VQA 方法将是一大发展重点。客观VQA方法现存的主要问题是视频数据集的内容不丰富、样本不平衡,这不利于它的发展;其次,大多算法模型在人为制造的失真数据上能够得到好的效果,但对于自然失真数据难以达到好的效果;再者,大部分VQA方法未能使用到实际应用中。

综上,VQA 的研究还有许多问题,需进一步探索。现对未来的发展方向进行推断,具体包括以下几个方面:

(1)从IQA 到VQA 的改进:当前的VQA 大多借鉴IQA 中的方法,或是从IQA 中得到启发灵感。如V-MEON算法的启发来源于对于图像的质量评价方法MEON[39],将2D 卷积改为了3D 卷积,并增加滤波器的选择,以此应用于视频的质量评估上。

(2)从FR-VQA 到NR-VQA 的推进:由于具有规范性、代表性的公开视频数据库稀少,以及自制视频数据成本高,难以达到,致使大多FR-VQA 方法依旧无法获得样本丰富、数据量大的原始视频源,虽能使用迁移学习弥补,但难以考究模型的泛化能力,又因为FR-VQA方法无法应用于实际情况的局限性,因此将FR-VQA向NR-VQA推进将是一个必要的趋势。

(3)扩大数据规模:一方面扩大现有的公共数据库,增加失真类型的种类,丰富视频数据库,为训练模型提供数据基础;另一方面,为应对视频类型的多样化,创建更健全、更合适的视频数据库是必不可少的,如立体视频数据库、全方位视频数据库以及VR视频数据库等。

(4)视听联合的质量评价:视频中往往伴随着声音,音频与视频之间的相互关系是复杂的,如视频失真可能导致音频无法与视频人物口唇同步,使得最终用户的体验质量不佳。因此,视听联合的质量评价是非常有必要的,而现有的音视频质量评价方法,都集中在单模式的视觉或音频信号上研究[81],未对视听结合进行探索,这并不满足实际情况的应用。因而,对于视听联合的质量评价研究进展还需要进一步探索音频和视频之间的相互影响,以应用于视频会议或远程服务类的实时在线视频质量监控上。

(5)构建/改进评价标准:视频多方法评估融合(VMAF)方法是最偏向主观的视频质量评价度量标准,但依旧存在未利用到时间信息的问题。在后来的改进方法[82]中,准确率和速度得到很大提升,但仍未利用到深层次的时域特征和色度特征。因此,构建/改进更加符合主观质量的视频质量评价标准将是一大挑战。

(6)客观评价与主观评价的一致性:客观评价的最终目的是要与人类主观感知达到一致,由于人类视觉系统的复杂性,致使现有的客观评价方法与主观评价方法在准确率方面还存在差距。客观评价要做到和主观评价精确一致还需研究。

5 结束语

由于人类感知的复杂性,在观察视频时易出现时间掩蔽效应和时间滞后效应等情况,而目前对人类感知的认识和研究还不够深入,致使对视频质量评价的研究较为缓慢。要想提高视频质量评价算法整体的准确度和速度,还需从人类内容感知方向进一步研究。且为应对市场的需求,现今的质量评估方法已经不仅仅是对二维视频进行研究。随着视频种类的增多,立体视频、全方位视频和虚拟现实视频已经分布在大众视野之中,而对于这类视频的研究热度也是逐渐上升的,为其提供可靠适用的算法是非常必要的。

总之,目前的视频质量评价还处于探究阶段,仍有许多问题有待解决,对视频方面的研究依旧是一个艰难的挑战。相信随着深度学习领域的发展,计算机视觉处理将得到更大改进与提高。